目录

从零到一,为你的 AI Agent 搭建一套可落地的评测体系

你好!作为 AI 小白,想要评估自建 Agent 的好坏,却不知从何下手?别担心,这份指南就是为你准备的。我们将用最通俗的语言,带你一步步了解 Agent 评测(Benchmark)的核心思想、具体方法和实操步骤,帮助你搭建一套科学、务实且能真正指导业务优化的评测体系。

1 Agent 评测是什么,为何如此重要?

Agent 评测(Benchmark)可以理解为一套标准化的 “考卷” 和 “评分规则”,用于系统性地衡量你的 AI Agent 在各类任务中的表现。它不是一次性的测试,而是一个持续的、量化的评估过程。

它的核心价值在于:

- – 连接技术与业务: 将模糊的 “好用” 或 “不好用”,转化为具体的、可量化的指标(如任务成功率、响应时间),让技术迭代的目标与业务价值直接挂钩。

- – 驱动模型优化: 通过评测发现 Agent 的短板(比如经常理解错某个指令,或调用某个工具失败),为模型微调、Prompt 优化或工具链改进提供明确方向。

- – 保障上线质量: 在 Agent 上线前进行充分 “体检”,确保其性能、稳定性和安全性达标,避免将一个 “半成品” 推给用户,造成负面体验或业务损失。

- – 科学决策: 当你有多个模型、多个版本的 Prompt 或多种技术方案时,Benchmark 提供了客观的数据依据,帮助你做出 “哪个版本更好” 的决策

简单说,没有评测,Agent 的优化就像 “蒙眼狂奔”,方向不明,效果难测。而一套好的评测体系,则是指引方向的 “指南针” 和衡量进展的 “里程表”。

2 评测场景分层:从实验室到真实战场

Agent 的评测不是单一场景,而是分层次、分阶段进行的。理解这些层次,有助于你规划全面的评测策略。

离线评测 (Offline):在 Agent 上线前,使用预先准备好的 “模拟任务数据集” 进行测试。这就像是 “模拟考”。

- – 优点: 安全、可控、可重复,适合快速迭代和版本回归测试。

- – 缺点: 数据集可能与真实用户场景存在偏差。

在线评测 (Online):将 Agent 投入真实环境,用 “真实用户流量” 进行测试,通常采用 A/B 测试或灰度发布。这就像是 “实战演练”。

- – 优点: 结果最真实,直接反映用户体验和业务影响。

- – 缺点: 风险高,需要完善的监控和回滚机制。

在每个评测阶段,任务的复杂度也不同:

- – 单轮任务 vs. 多轮对话: 前者是 “一问一答” 即可完成,后者则需要 Agent 在连续多轮交互中理解上下文。

- – 纯模型 vs. 带工具系统: 前者只评估语言模型的对话或推理能力,后者则要评估 Agent 调用外部工具(如查询数据库、调用 API)完成复杂任务的能力。

3 核心评测维度清单:衡量 Agent 的 “德智体美劳”

一套全面的评测体系需要从多个维度考察 Agent。以下是面向业务落地的核心指标:

| 维度 | 核心问题 | 简要说明 |

| 任务成功率 (Success Rate) | 它完成任务了吗? | 最核心的指标,衡量 Agent 是否从根本上解决了用户的问题。 |

| 准确性/事实性 (Accuracy/Factual) | 它说对了吗?有没有胡说八道? | 评估 Agent 回答的正确性,特别是对抗 “幻觉”(Hallucination)的能力。 |

| 效率 (Efficiency) | 它做得快不快?步骤多不多? | 包括响应时长、完成任务所需的步骤数或工具调用次数。 |

| 成本 (Cost) | 完成一次任务花了多少钱? | 衡量大模型推理成本、外部 API 调用费用等,直接关联业务的 ROI。 |

| 鲁棒性 (Robustness) | 遇到异常情况会崩吗? | 测试 Agent 在面对模糊指令、异常输入或外部系统故障时的处理能力。 |

| 稳定性 (Stability) | 新版本有没有把旧功能搞坏? | 通过回归测试,确保新版本 Agent 的性能不低于基线版本。 |

| 安全与合规 (Security & Compliance) | 它有没有越权或泄露隐私? | 检查是否存在越权操作、数据泄露、生成敏感或违规内容等风险。 |

| 用户体验 (User Experience) | 用户用得爽不爽? | 主观指标,如回答的可解释性、流畅度,以及通过用户满意度调研(NPS)来衡量。 |

4 评测实操步骤

第 1 步:设计业务任务集

评测的起点是定义好 “考题”。你需要将复杂的业务流程,拆解成一个个 “最小可测单元”。

核心方法:从真实的用户场景和业务流程出发,定义清晰的输入、期望输出和成功标准。

典型任务模板:

- 信息检索:输入 “查询订单号 12345 的状态”,输出 “已发货”。

- 表单填充:输入 “帮我预订明天下午 3 点到总部的会议室”,Agent 需调用系统完成预订。

- 数据分析:输入 “统计上周华东区的销售额”,输出正确的金额。

- 工具链编排:输入 “帮我查一下张三最近的报销单,并把金额和事由发邮件给他确认”,Agent 需依次调用查询、邮件两个工具。

第 2 步:构建数据集与标注规范

有了 “考题” 框架,就需要准备具体的 “题目”——测试数据集。

- 样本来源:可以从真实的历史用户日志中清洗,也可以由业务专家根据经验设计,或通过仿真程序构造。

- 难度分级:将样本分为简单、中等、困难等级,便于分析 Agent 在不同复杂度任务下的表现。

- 标注规范 (Gold 标准):为每个测试样本制定一个标准答案或理想的执行结果。这是后续评分的基准。为降低主观性,标准应尽可能明确,例如 “金额完全一致” 或 “包含 ‘已发货’ 和 ‘物流单号’ 两个关键词”。

第 3 步:实施评分方法

评分方法分为自动和人工两种,通常是两者结合。

自动化评分:对于有明确结果的任务,可以通过代码自动判断对错,效率极高。

- 可编程判定:如字符串完全匹配、JSON 结构比对。

- 容错匹配:允许一定的同义词或数值误差(如金额误差在 1% 以内)。

- 函数式断言:编写一个函数来校验业务规则,如 “返回的订单日期必须晚于下单日期”。

- 工具执行结果核验:检查 Agent 调用的工具 API 是否成功,以及参数是否正确。

可以对多个指标进行加权计分,得到一个综合分数。

人工评审:对于主观性强的任务(如内容创作的质量)或需要评估安全风险的场景,人工评审不可或缺。

- 人审面板:设计清晰的打分表,包含多个维度(如流畅性、相关性、安全性),每个维度有明确的刻度(如 1-5 分)。

- 一致性控制:采用多人背靠背打分(双审),对分歧大的 case 进行仲裁,以保证评价标准的一致性。

第 4 步:进行各类专项测试

除了常规的功能测试,还需要进行专项测试来确保 Agent 的全面能力。

安全与合规测试:构造一些 “危险” 指令,测试 Agent 是否会:

- 越权调用工具(如尝试删除数据库)。

- 泄露用户隐私或公司敏感数据。

- 响应并生成黄赌毒、政治敏感等违规内容。

鲁棒性与对抗性测试:模拟真实世界中的 “不完美” 输入,测试 Agent 的应对能力:

- 脏输入:错别字、口语化表达、模糊指令。

- 长上下文:在很长的对话后,Agent 是否还能记住前面的关键信息。

- 故障注入:模拟调用的工具 API 超时或返回错误,看 Agent 是否能妥善处理并告知用户。

版本管理与回归测试:每当模型、Prompt 或工具更新后,都需要进行回归测试:

- 设定基线:将当前稳定版本的评测结果作为基线(Baseline)。

- 运行回归套件:用一套固定的、覆盖核心功能的测试集,在新版本上跑一遍。

- 对比结果:确保新版本的核心指标没有下降(或在可接受的阈值内),避免 “修复一个 bug,引入三个新 bug”。

第 5 步:在线评测与持续监控

离线评测通过后,就可以进入 “实战” 了。在线评测(通常是 A/B 测试)是检验 Agent 真实价值的终极手段。

你需要关注:

- 流量切分:将一小部分用户流量(如 1%)分配给新版 Agent,其余用户仍使用旧版。

- 指标采集:实时收集两组用户的业务指标,如转化率、任务耗时、用户满意度评分等。

- 显著性分析:通过统计学方法判断新旧版本在指标上的差异是否真实有效,而非随机波动。

- 风控预案:一旦新版 Agent 出现严重问题(如成功率暴跌、成本激增),必须有能力迅速将其下线,全量切回旧版。

5 从 “最小起步方案” 开始:你的第一周落地清单

理论很多,但行动最重要。你可以从一个最小化的方案开始,在短短一周内跑通整个评测流程。

- 选择任务:挑选 3 个最高频的核心业务任务。

- 定义标准:为每个任务清晰地定义输入、期望输出和成功判定标准。

- 创建样本:为每个任务手工构造 10~50 条测试样本,覆盖常见和边界情况。

- 编写脚本:针对这些任务,编写简单的自动化评分脚本(如 Python 脚本)。

- 跑出基线:在当前 Agent 版本上运行这套测试,得到第一份离线评测报告,作为基线。

- 在线灰度:如果离线表现良好,可以尝试对极小部分内部用户或种子用户开放,收集真实反馈。

- 建立仪表盘:将核心指标(任务成功率、耗时、成本)做成一个简单的仪表盘,实现可视化监控。

6 评测结果的应用:报告、决策与优化

评测不是为了分数,而是为了洞察和行动。

报告与可视化。评测结果应通过仪表盘清晰呈现:

- 核心仪表盘:展示总体的任务成功率、平均响应时长、平均成本、错误类型分布等。

- 下钻分析:支持按不同任务类型、不同场景、不同模型版本进行拆解,定位具体问题。

成本与效益评估。评测数据能帮助你做 “性能 – 成本” 权衡:

- 性能 vs 成本:更强的模型(如 GPT-4)可能成功率更高,但成本也更高。通过评测数据,你可以判断这种性能提升是否值得额外的成本支出。

- 价值估算:将 Agent 节省的人力工时或带来的业务增长,与它的开发和运营成本进行对比,估算 ROI。

7 常见陷阱与规避

在搭建评测体系时,新手容易遇到一些坑。了解它们,可以帮你少走弯路。

| 常见陷阱 | 规避方法 |

| 任务定义不清 | 为每个任务制定极其明确的输入、输出和成功标准文档。 |

| 评分过度主观 | 尽可能自动化评分;人工评分时,制定详细的评分细则并进行一致性校验。 |

| 只看总分,不看拆解 | 总分可能掩盖局部问题。必须下钻到具体任务和错误案例进行分析。 |

| 忽视安全与回滚 | 上线前必须进行严格的安全测试,并确保在线评测有可靠的回滚机制。 |

8 组织与治理

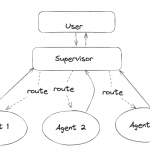

一个成功的 Agent 项目,离不开明确的角色分工和治理流程。

- 角色分工:业务方负责定义任务和成功标准;研发负责 Agent 实现和优化;数据/标注团队负责数据集构建;风控团队负责安全合规审核。

- 上线准入:设立明确的评测审批门槛,只有通过基线评测(包括功能、性能、安全)的 Agent 版本才能上线。

- 例会与节奏:定期(如每周)召开评测复盘会议,回顾核心指标变化,分析 bad case,并制定下一周期的优化计划。

术语速查表

Benchmark:基准测试,一套标准化的评估框架。

Gold 标注:指为测试样本制作的 “黄金标准答案”。

断言 (Assertion):在自动化脚本中,用于判断结果是否符合预期的代码逻辑。

A/B 测试:一种在线实验方法,通过比较两个或多个版本的效果来做决策。

显著性:统计学概念,用于判断实验结果的差异是真实有效还是随机巧合。

回归套件 (Regression Suite):一套用于检查新版本是否破坏了原有核心功能的测试用例集。